IA et « sensitivity readers » : vers une littérature aseptisée ?

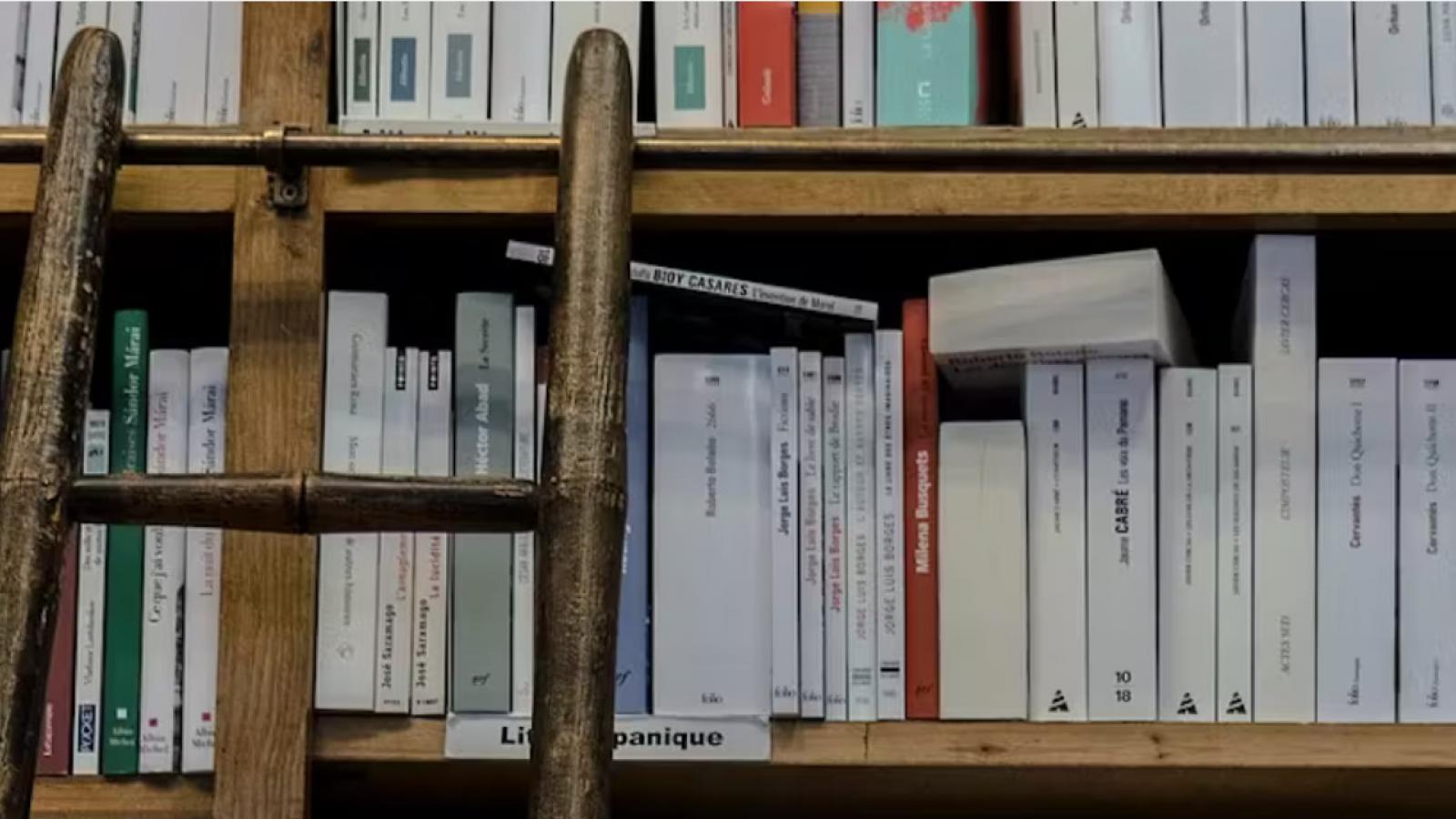

La tendance actuelle est à l’encouragement à la création littéraire. Pour s’en convaincre, il suffit d’observer les tables des librairies qui regorgent de méthodes proposant des conseils rapides et efficaces pour écrire un bon roman, en passant par des applications sur le net spécialisées dans le « coaching » littéraire offrant des masterclass, des webinaires ou des tutos en ligne sans oublier la multiplication des formations universitaires en France en création littéraire.

Cet engouement pour la recherche du « style parfait » affiche un niveau inédit avec l’arrivée de puissants outils originaires des États-Unis : les intelligences artificielles génératives. Ces impressionnants outils remettent en question le travail des auteurs qui y recourent pour écrire avec plus de facilité. À ce phénomène s’ajoutent les conseils des « sensitivity readers », ou « des lecteurs en sensibilité », supposés rendre une œuvre irréprochable en n’heurtant personne. Employés par des éditeurs ou des auteurs, ces relecteurs sont en effet des personnes chargées d’examiner une œuvre littéraire avant sa publication afin de débusquer des contenus pouvant choquer ou offenser des lecteurs ou lectrices.

Ces outils aux contours attractifs ne s’érigent-ils pas au contraire en frein à la création ou en moteur incitatif à l’uniformisation littéraire ?

Ma muse, ô mon IA

Depuis l’arrivée des intelligences artificielles génératives en novembre 2022, certains auteurs n’hésitent plus à avoir recours aux chabots pour écrire leur texte. En 2023, c’est en effet plus de 1000 ouvrages écrits ou coécrits par le robot conversationnel qui ont été recensés, notamment sur le site Kindle Direct Publishing d’Amazon. Soudainement sont apparus sur le site marchand des livres culinaires, des guides de voyage, mais aussi des biographies ou encore des livres jeunesse, tous écrits par un robot conversationnel avec généralement de nombreuses maladresses.

Au-delà de la plate-forme du géant de Seattle, cet outil est également parvenu à s’immiscer dans le cercle très fermé des prix littéraires. Rie Kudan, une romancière Japonaise, a en effet été récompensée par le prestigieux prix Akutagawa, le « Goncourt Japonais » pour son roman Tokyo Sympathy Tower écrit avec l’aide de ChatGPT. De même, pour Shen Yang : il a gagné un prix littéraire de science-fiction en Chine en écrivant une nouvelle en 3 heures et en 66 prompts, faisant ainsi du prompt une nouvelle métrique dans la création littéraire.

Quand certains écrivains, par exemple James Frey, utilisent l’IA pour tenter d’écrire le meilleur livre possible, d’autres démontrent au contraire que, loin de favoriser une nouvelle forme de créativité, les publications générées par des robots révèlent une similitude troublante. Alimentées et entraînées par un corpus de données humaines qui ont été au préalablement triées, normalisées, et organisées, les intelligences artificielles génératives ne créent pas en l’état des textes innovants mais proposent une sorte de recyclage littéraire en continu, susceptible d’être qualifié de littérature circulaire.

C’est l’expérience qu’a menée l’auteure Juliette Mezenc lors de sa performance poétique en utilisant ChatGPT. En demandant au robot conversationnel d’écrire un poème à la manière de Juliette Mezenc, cette poétesse a réussi à démontrer le vide littéraire de ChatGPT. Au fil de ses prompts, elle a stratégiquement épuisé les ressources littéraires de ce robot, démontrant que ses capacités se limitaient à un remixage continuel de vers simulant la création.

IA et sensitivity readers : un cocktail littéraire impersonnel

Cette intrusion de l’IA dans le paysage littéraire met le plus souvent sur le marché des textes écrits à la manière de ChatGPT ou autres robots, c’est-à-dire des textes les plus aseptisés possibles et capables de convenir à tous, devenant le sésame littéraire comme sous l’effet des sensitivity readers.

Cette dernière tendance, elle aussi venue des États-Unis, consiste à détecter et à gommer des phrases ou des situations embarrassantes pour certains lecteurs ; elle est désormais de plus en plus employée par les maisons d’édition afin d’éviter toute agitation médiatique lors d’une parution.

Plusieurs auteurs ont vu en effet leur texte passer sous la plume de relecteurs d’un nouveau genre. Tel est le cas, par exemple, de l’autrice Daphné Palasi Andreades avec son roman Brown Girls publié en 2023, qui raconte la diaspora philippine aux États-Unis.

Afin d’éviter toute stigmatisation, le titre original n’a pu être traduit littéralement en français. Un an après sa publication originale, l’éditrice lui a préféré Les Filles comme nous.

Les romans contemporains ne sont pas les seuls à être revisités, les écrits des certains auteurs classiques passent aussi au crible de la réécriture à l’instar de ceux de Rohald Dahl ou d’Agatha Christie dont des passages ont été modifiés et réécrits. Le très célèbre roman policier Dix petits nègres, écrit en 1938 et vendu pourtant à plus 100 millions d’exemplaires dans le monde, est subitement devenu en 2020 Ils étaient dix.

Ces exemples révèlent qu’une mutation se produit dans le domaine littéraire. Avec l’IA et les sensitivity readers, une partie des professionnels du livre semble avoir désormais recours à une stratégie d’évitement afin d’adapter leur politique éditoriale à un marché minutieusement balisé.

Il ne s’agit plus de rechercher l’originalité ou la surprise et encore moins de choquer voire provoquer le scandale comme cherchaient à le faire autrefois certains éditeurs. Conscients de la manne financière que pouvait procurer une polémique constructive, des éditeurs, comme Bernard Grasset ou encore René Julliard n’hésitaient pas à publier des romans capables de bousculer les mentalités à l’instar de la jeune Françoise Quoirez, plus connue sous le nom de Françoise Sagan dont le mince roman Bonjour tristesse parut en 1954 fit d’elle une romancière à contre-courant. « Le scandale c’est le talent, quand les gens sont attrapés directement par les cheveux et qu’on les frappe par une phrase » disait-elle dans un entretien mené par André Halimi en 1973.

Désormais, il s’agit au contraire d’être le plus policé possible afin de convenir à tous les lecteurs, à toutes les sociétés pour ne pas déranger ni froisser et encore moins critiquer.

En s’inféodant aux intelligences artificielles et aux sensitivity readers, le marché du livre semble à présent « éviter les idées PROBLEMATIQUES, le MALAISE […] le RISQUE ». C’est l’idée directrice du roman intitulé Sensibilités écrit par Tania de Montaigne, dont l’une des publications a aussi fait l’objet d’un important remaniement par des « lecteurs en sensibilité » :

« C’était ça la clé : ne blesser personne, lisser les aspérités pour permettre aux lecteurs d’être au mieux, d’être BIEN. […] La clé était de parvenir à désactiver les mots et les idées problématiques pour en offrir une version équivalente et inoffensive. Ne rien proposer qui puisse donner prise à l’OFFENSE. Surtout, que personne ne soit AGRESSÉ. »

Devant ce filtrage à coups de prompts et de relectures démesurées, il est possible de se demander si l’intelligence artificielle, sans oublier les sensitivity readers, ne représenteraient pas au fond une forme de censure. N’assiste-t-on pas désormais à une régulation du marché littéraire dont l’objectif serait de fabriquer une littérature monocorde et éloignée de toute singularité ?

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

C’est la question que se pose également Antoine Gallimard, suite à son expérience avec Llama, l’IA de Méta, qui refuse d’écrire « à la manière de Michel Houellebecq » estimant que les propos de cet auteur français, pourtant de renommée mondiale, sont trop injurieux pour être générés. Ce refus de la machine de créer des textes sujets à la polémique semble révéler « un modèle de société qui ne fait pas grand cas de la complexité de l’expérience humaine et qui s’arroge le droit, depuis la côte ouest des États-Unis, de dire ce qu’il est bon ou ce qu’il n’est pas bon de penser », dénonce le célèbre éditeur.

Pour éviter une situation semblable, les auteurs comme les éditeurs ont tout intérêt à faire preuve de vigilance devant le risque de platitude littéraire engendré par les robots conversationnels et les démineurs éditoriaux. Les lecteurs pourraient aussi être informés du contexte d’une publication dans un avant-propos, par exemple.

Pourtant, à bien y réfléchir, ce n’est pas vraiment le recours à ces outils qui pose un problème, car leur utilisation peut être d’une efficacité redoutable suivant les situations. Ce qui semble particulièrement néfaste c’est la dépendance voire la dépersonnalisation scripturale sous-jacente que ces outils peuvent entraîner. La banalité et l’impersonnalité des phrases créées sans nervure ni ironie, composées à l’infini d’idées remixées, risquent effectivement d’appauvrir les écrits des auteurs, eux-mêmes piégés par une facilité d’écriture à portée de main et par une paix éditoriale (pré) fabriquée.

- Se connecter ou s'inscrire pour publier un commentaire

- 83 vues

Connexion utilisateur

Dans la même rubrique

Pâmela Carvalho

23/01/2026 - 10:47

Mustafa Benfodil ("El Watan.dz")

14/12/2025 - 10:42

Commentaires récents

S'amuser à se faire peur pour rien...

INCAPABLE...

Albè

05/02/2026 - 16:45

...de coloniser le Canada ou le Groënland, territoires remplis de richesses minières, Trump songe Lire la suite

S'amuser à se faire peur pour rien...

Comment pouvez vous affirmer...

Frédéric C.

05/02/2026 - 14:17

...avec certitude que Trump-2 ignore l’existence même de nos pays ? Lire la suite

Saint-Esprit : le bilan de la mandature de Fred-Michel Tirault

Je précise ma pensée :

yug

05/02/2026 - 12:46

Accuser: Présenter qq'un comme coupable (Larousse)

Lire la suiteSaint-Esprit : le bilan de la mandature de Fred-Michel Tirault

POVRE CONARD, VA !

Albè

05/02/2026 - 11:00

Donc les articles du communiste-autonomiste Michel Branchi et de l'indépendantiste-CNCP Robert Sa Lire la suite

Saint-Esprit : le bilan de la mandature de Fred-Michel Tirault

Vidéo-tract électoral

yug

05/02/2026 - 10:40

Je me fous des départementalises ,de Branchi ou du CNCP..Ce que je sais c'est que cet "ARTICLE" e Lire la suite

Top 5 des articles

Aujourd'hui :

- Hilarante campagne électorale dans l'île aux fleurs fanées

- L'île paradisiaque dont les habitants n'ont pas le droit d'utiliser les plages

- Il devrait prendre des cours d'...anglais !

- BOUVIER SE COMPORTE EN COWBOY ET NOUS PREND POUR DES INDIENS !

- Degano racconta la storia di un’Italia multiculturale

Depuis toujours :

- Tous les présidents et premiers ministres de la Caraïbe sont vaccinés

- L'intolérable appauvrissement intellectuel et culturel de la Guadeloupe et dans une moindre mesure de la Martinique !

- LETTRE OUVERTE AU 31ème PREFET FRANCAIS DE MARTINIQUE

- L'arrière-grand-père maternel de Joan Bardella était...algérien

- Les triplement vaccinés contre le covid ne bandent plus